Compression des images hyperspectrales

These en pdf

Chapitre 2

Critères qualité pour les images hyperspectrales

APRÈS avoir défini les particularités du domaine de l’hyperspectral et

avant de commencer l’étude de la compression des images hyperspectrales,

il est nécessaire de définir un ou plusieurs critères de qualité image. Ces critères

permettront de comparer les différentes méthodes de compression et, en

particulier, de mesurer les différents types de dégradations causées par les

diverses méthodes de compression. Le terme de critère qualité est tout d’abord

précisé, ainsi que son intérêt pour évaluer les performances de compression. Les

critères qualité classiques sont ensuite énumérés et leur adaptation aux

images hyperspectrales est faite (2.1). Une démarche est ensuite proposée

pour évaluer l’adéquation de ces critères aux applications typiques des

images hyperspectrales (2.2). Enfin, des critères sont sélectionnés pour leur

bonne complémentarité (2.3). Cette partie de l’étude a fait l’objet de

publications [Chr05a,Chr05b,Chr05c].

2.1 Taxinomie des critères qualité

2.1.1 Définition

Le terme de qualité image ou de critère qualité n’est pas un terme intuitif, il est donc nécessaire de préciser sa signification. La définition suivante est commune au CNES et à l’ONERA et est tiré d’un rapport commun [Kat99]. Cette définition couvre le domaine de l’acquisition d’image en général et n’est pas orienté spécialement pour l’imagerie hyperspectrale.

La notion de qualité image est indispensable pour caractériser le besoin selon les applications. Cette notion est donc relative et dépend du besoin en aval. Les critères de qualité image qualifient toute la chaîne image, depuis la scène observée jusqu’au produit final. Tous les aspects de la chaîne doivent donc être pris en compte, ce qui inclut la partie instrumentale (optique, détection des photons, chaîne électronique), les traitements bord (quantification, égalisation, compression), la plate-forme (contrôle d’attitude et orbite, architecture mécanique), mais également les traitements sol (débruitage, corrections radiométriques et géométriques) effectués avant la distribution de l’image.

Les critères adoptés sont fortement liés aux caractéristiques des instruments : bruit radiométrique, FTM (Fonction de Transfert de Modulation), localisation, altération des longueurs, … Certains critères sont plus difficiles à définir. C’est le cas par exemple d’un critère rendant compte des artefacts structurés créés par une compression de type JPEG.

Pour les images classiques, cette notion de qualité image peut être classée en trois domaines : la géométrie, la radiométrie et la FTM. La FTM, fortement liée à la radiométrie est aussi dépendante de la géométrie, c’est pour cela qu’elle est classée dans une catégorie particulière. Dans le cas des images hyperspectrales, la dimension spectrale devra faire l’objet d’une attention particulière puisque c’est principalement selon cette dimension que fonctionnent les applications. Cette anisotropie au niveau des dimensions, tant au niveau des propriétés statistiques que des utilisations qui en sont faites rend délicate l’adaptation des critères qualité existants.

2.1.2 Intérêt pour la compression

Lorsque l’on utilise des techniques de compression avec pertes, l’utilisation de mesures de qualité est indispensable pour l’évaluation des performances. D’après Eskicioglu [Esk95], le problème majeur dans l’évaluation des techniques de compression avec pertes réside dans la difficulté à décrire la nature et l’importance des dégradations sur l’image reconstruite.

Cette notion de critère qualité, en adéquation avec les applications en aval, est donc particulièrement intéressante pour évaluer l’impact d’un procédé de compression sur l’exploitation de l’image finale.

2.1.3 Méthodes d’évaluation

Dans la suite, on appelle bruit toutes les modifications sur les données causées par le système. Ce bruit peut donc provenir des parties optique, électronique et numérique selon le système considéré. Le flou causé par la FTM, une déregistration entre les bandes, aussi bien que les changements de valeurs causés par la quantification seront regroupés sous le terme de bruit.

Dans le cas des images classiques, plusieurs méthodes d’évaluation sont utilisées.

- Méthodes subjectives : basées sur l’évaluation de la qualité par des observateurs humains. Ces méthodes consistent à faire attribuer une note de qualité (Mean Opinion Score ou MOS) par un panel d’observateurs. Cette notation, lourde à mettre en œuvre, est adaptée lorsque les images sont exploitées par des observateurs humains (photo-interprètes).

- Méthodes objectives : basées sur des critères mathématiques pour évaluer la qualité des images. Les critères qualité utilisés pour mesurer les performances des instruments optiques sont, par exemple, le rapport signal/bruit (RSB ou SNR), l’erreur quadratique moyenne (EQM ou MSE). Ces méthodes sont surtout efficaces pour mesurer l’influence d’un bruit blanc, mais sont mal adaptées lorsque les dégradations sont structurées (blocs, rebonds aux abords des contours,…). La Fonction de Transfert de Modulation (FTM ou MTF) permet de prendre en compte des dégradations spécifiques.

Dans le cas hyperspectral, les images sont surtout exploitées à l’aide de programmes informatiques, les critères d’évaluation utilisant des observateurs humains seront donc moins pertinents.

Les méthodes de calcul de ces critères mathématiques peuvent être de deux sortes, selon qu’on a accès ou non à l’image originale :

- Les méthodes bivariantes ou full-reference fonctionnent avec une comparaison par rapport à l’image originale. Ces méthodes sont généralement les plus efficaces, mais nécessitent d’avoir accès à l’image non dégradée.

- Les méthodes univariantes sont basées sur une estimation des critères de qualité lorsqu’on ne possède que l’image finale.

- Il existe également une méthode intermédiaire par références réduites à l’image originale. En plus de l’image codée, on transmet certains paramètres de l’image originale (moyenne, variance...). Une évaluation de la dégradation est possible à partir de ces données. C’est une technique qui est notamment utilisée dans les applications de transmission liées à la qualité de service (QoS) [Car03].

Bien sûr, les méthodes bivariantes sont plus robustes. Dans le cas de l’évaluation de la compression d’image, on dispose des images originales. Il est donc plus efficace d’utiliser des critères bivariants.

2.1.4 Les méthodes bivariantes

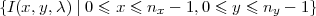

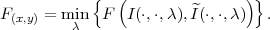

Les méthodes bivariantes sont basées sur des critères de distances entre

l’image originale et l’image après passage dans la chaîne image. Dans

notre cas, il s’agit de l’image originale, sans compression, notée I, et de

l’image obtenue après compression-décompression dont on veut évaluer les

distorsions, notée  . Les images hyperspectrales sont représentées sous la

forme d’une matrice tridimensionnelle : I(x,y,λ), x est la position du

pixel dans la ligne, y est le numéro de la ligne et λ la bande spectrale

considérée. nx, ny et nλ sont respectivement le nombre de pixels par ligne, le

nombre de lignes et le nombre de bandes spectrales. On notera également

∑

x=1nx ∑y=1ny ∑λ=1nλI(x,y,λ) par ∑x,y,λI(x,y,λ). Ces notations seront

conservées par la suite.

. Les images hyperspectrales sont représentées sous la

forme d’une matrice tridimensionnelle : I(x,y,λ), x est la position du

pixel dans la ligne, y est le numéro de la ligne et λ la bande spectrale

considérée. nx, ny et nλ sont respectivement le nombre de pixels par ligne, le

nombre de lignes et le nombre de bandes spectrales. On notera également

∑

x=1nx ∑y=1ny ∑λ=1nλI(x,y,λ) par ∑x,y,λI(x,y,λ). Ces notations seront

conservées par la suite.

Les mesures bivariantes pour les images hyperspectrales peuvent être classées en 3 types :

- Une extension isotrope des critères classiques issus du traitement du signal. À l’origine, ces traitements sont adaptés à des données à une seule dimension. Ils ont été ensuite étendus avec succès aux images classiques à deux dimensions. Pour les images hyperspectrales, des extensions à une troisième dimension ont été réalisées. Dans ce premier groupe, on considère les critères traitant les 3 dimensions (2 spatiales et une spectrale) de la même manière. La spécificité des images hyperspectrales n’est donc pas prise en compte.

- Le second groupe contient les critères spécifiques aux images hyperspectrales. Ces critères fonctionnent de manière non symétrique (moyenne d’un critère classique sur l’ensemble des pixels considérés comme des vecteurs par exemple). Ce type de critère permet d’insister sur certaines propriétés du spectral par rapport au spatial.

- Le troisième groupe contient des critères statistiques évolués adaptés de plusieurs manières aux images hyperspectrales.

2.1.5 Extension isotrope de critères de traitement du signal

Dans cette partie, les critères sont directement tirés des mesures statistiques classiques. Chaque valeur est considérée individuellement selon les dimensions spatiales et spectrale. Il n’est pas tenu compte de la différence de nature entre les deux types de dimension. L’aspect structurel des erreurs n’apparaît pas. Par la suite, d’autres mesures seront considérées qui prendront la dimension spectrale sous forme d’un vecteur par exemple.

Les mesures les plus utilisées sont issues des normes  p et basées sur les

distances associées.

p et basées sur les

distances associées.

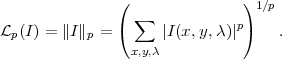

La norme  p est définie par :

p est définie par :

| (2.1) |

La distance correspondante, également appelée distance de Minkowski, est définie par

| (2.2) |

Ces mesures sont ensuite normalisées de différentes manières pour les rendre plus ou moins indépendantes de la taille et de la nature des données originales. Ceci nous permet de proposer un certain nombre de critères listés ci-après.

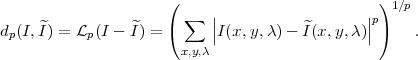

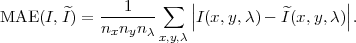

∙ Mean Absolute Error (MAE) ou moyenne de  1. On moyenne ici par le

nombre de pixels pour rendre la mesure indépendante de la taille de

l’image.

1. On moyenne ici par le

nombre de pixels pour rendre la mesure indépendante de la taille de

l’image.

| (2.3) |

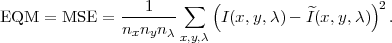

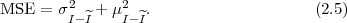

∙ Erreur Quadratique Moyenne (EQM) ou Mean Square Error (MSE) ou

moyenne de  22. Ici, on moyenne également sur le nombre de pixels.

22. Ici, on moyenne également sur le nombre de pixels.

| (2.4) |

Pour une meilleure interprétation, cette mesure peut être reliée à des notions de moyenne et variance. En notant μU la moyenne de l’ensemble U et σU2 sa variance,

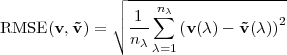

∙ RMSE (Root Mean Square Error) à ne pas confondre avec  2.

2.

| (2.6) |

| (2.7) |

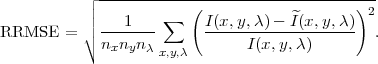

∙ Relative RMSE (RRMSE) : on normalise en plus ici avec le niveau du signal, ce qui sous entend qu’une erreur de même amplitude sera moins gênante sur un signal important que sur un signal faible.

| (2.8) |

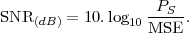

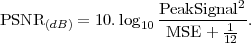

∙ Les méthodes issues du traitement du signal fonctionnent surtout avec le Rapport Signal sur Bruit (RSB) ou Signal to Noise Ratio (SNR). On met ici en rapport la puissance de l’erreur avec la puissance du signal original (PS).

| (2.9) |

Lorsque le signal est de moyenne nulle, on a PS = σI2. En revanche, quand ce n’est pas le cas, une ambiguïté existe sur la définition de la puissance du signal, certains gardent la variance pour exprimer la puissance du signal (puissance du signal centré en fait) et d’autres choisissent la puissance réelle du signal.

On trouve également dans [Aia01] la formulation suivante :

| (2.10) |

Le facteur  correspond à l’erreur de quantification. Introduire ce facteur

permet de borner les valeurs du SNR lorsqu’il n’y a pas de pertes. La

puissance de l’erreur de quantification, lorsque le nombre de bits est

important, s’approche de

correspond à l’erreur de quantification. Introduire ce facteur

permet de borner les valeurs du SNR lorsqu’il n’y a pas de pertes. La

puissance de l’erreur de quantification, lorsque le nombre de bits est

important, s’approche de  avec D le pas de quantification. Dans le cas

des images, le pas de quantification est de 1, le facteur devient donc

avec D le pas de quantification. Dans le cas

des images, le pas de quantification est de 1, le facteur devient donc  .

Cette définition est notamment utilisée par Aiazzi [Aia01]. Elle n’est

pas tout à fait en accord avec la définition usuelle du SNR. Néanmoins,

pour les valeurs usuelles de SNR (SNR < 60 dB), la variation entre les

deux définitions est au maximum de 0.4 dB. De plus, cette variation

décroît logarithmiquement : à SNR < 50 dB, la variation est inférieure à

0.04 dB.

.

Cette définition est notamment utilisée par Aiazzi [Aia01]. Elle n’est

pas tout à fait en accord avec la définition usuelle du SNR. Néanmoins,

pour les valeurs usuelles de SNR (SNR < 60 dB), la variation entre les

deux définitions est au maximum de 0.4 dB. De plus, cette variation

décroît logarithmiquement : à SNR < 50 dB, la variation est inférieure à

0.04 dB.

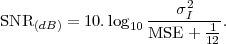

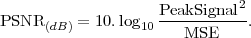

∙ Le PSNR (Peak SNR) est également utilisé. Il tient compte de la dynamique du signal. Dans le cas des images numériques, on a généralement PeakSignal = 2q, q étant le nombre de bits utilisés pour coder les valeurs, ce qui sous entend que la dynamique est bien dimensionnée.

| (2.11) |

De manière équivalente au SNR, on trouve dans [Aia01] la définition suivante :

| (2.12) |

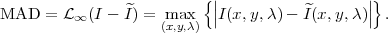

∙ Maximum Absolute Distortion (MAD) ou  ∞ ou Maximum Absolute Error

(ambiguïté avec l’abréviation MAE, utilisée par Motta [Mot03])

∞ ou Maximum Absolute Error

(ambiguïté avec l’abréviation MAE, utilisée par Motta [Mot03])

| (2.13) |

∙ Percentage MAD (PMAD) (également appelé Percentage Maximum Absolute Error, PMAE) correspond à la même notion que le Relative RMSE, on tient compte du niveau de l’erreur par rapport au niveau du signal initial.

C’est une mesure très utilisée, notamment par Pickering et Ryan [Bai01,Pic00,Rya98,Rya00]. La définition se trouve dans [Aia03a] :

| (2.14) |

Parmi ces critères, seuls  ∞ (2.13) et le PMAD (2.14) bornent l’erreur sur

l’ensemble de l’image. Les autres critères ne garantissent pas que des distorsions

locales importantes ne seront pas présentes même si ces distorsions locales ont un

impact très important sur les applications.

∞ (2.13) et le PMAD (2.14) bornent l’erreur sur

l’ensemble de l’image. Les autres critères ne garantissent pas que des distorsions

locales importantes ne seront pas présentes même si ces distorsions locales ont un

impact très important sur les applications.

Une utilisation du MAD pourrait être faite, par exemple pour borner l’erreur de compression sous le bruit introduit par la quantification. Dans ce cas, la compression serait virtuellement sans pertes.

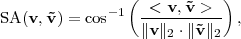

2.1.6 Critères orientés hyperspectral

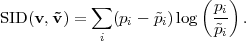

Les critères présentés ici sont spécialement adaptés au domaine de l’hyperspectral. Certains, comme le SAM sont très largement utilisés. On définit par v et ṽ respectivement un vecteur de l’image originale et un vecteur de l’image reconstruite contenant les nλ composantes spectrales du pixel (x,y).

2.1.6.1 Critères basés sur les vecteurs spectraux

Un ensemble de critères classiques peut être proposé :

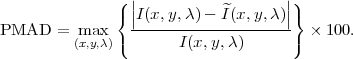

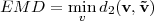

∙ Distance euclidienne minimale (Euclidean Minimum Distance (EMD) [Kes02]).

![┌ -----------------

││ ∑nλ

d2(v,˜v) = L2 (v - ˜v ) = ∘ [v(λ) - ˜v(λ)]2 (2.15)

λ=1

┌│ -n-----------------------

│∘ ∑ λ [ ^ ]2

= I(x, y,λ)- I(x,y,λ) . (2.16)

λ=1](these44x.png)

| (2.17) |

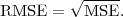

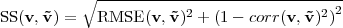

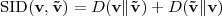

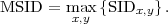

∙ Average RMSE (A-RMSE) : Ce critère réalise une moyenne du RMSE calculé pour chaque vecteur [Aia03a,Aia03b].

![∘ ----------------------------

1 ∑ 1 ∑ [ ]2

ARMSE = n-n-- n-- I(x,y,λ) - ^I(x,y,λ) (2.18)

x y x,y λ λ

----1----∑

= nxny√n-λ-x,y L2(v - ˜v). (2.19)](these46x.png)

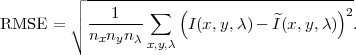

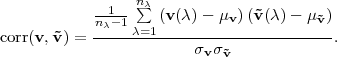

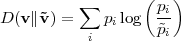

∙ Peak RMSE (P-RMSE) : Ce critère représente le RMSE maximum calculé selon les vecteurs.

![∘ -1-∑--[-------------------]2

PRMSE = max --- I(x,y,λ)- ^I(x, y,λ) (2.20)

x,y nλ λ

-1---

= √n-λ-mxa,xy {L2(v - ˜v)}. (2.21)](these47x.png)

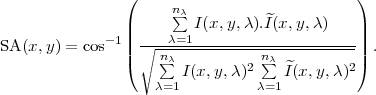

2.1.6.2 Maximum Spectral Angle (MSA)

Le Maximum Spectral Angle (MSA) est un critère utilisé dans de nombreux articles dont [Aia03a,Qia03,Kes02]. Le spectral angle est une mesure d’écart entre deux vecteurs. Pour chaque pixel, on mesure l’angle entre le vecteur original et le vecteur reconstruit. Il est plus rigoureux de parler de Spectral Angle pour définir la mesure entre deux vecteurs, le Spectral Angle Mapper désignant l’application de classification correspondant à cette mesure.

| (2.22) |

ou encore directement en utilisant les valeurs du cube hyperspectral :

| (2.23) |

Le SA est invariant par multiplication des vecteurs pouvant provenir d’une différence d’illumination ou d’orientation angulaire. Il est donc intéressant pour les images contenant des zones d’ombres et des zones plus fortement éclairées.

Ce critère peut être considéré en moyenne, ou bien en prenant le maximum de manière à borner l’erreur. Il faut toutefois noter que ce critère mesure les distorsions spectrales et que les distorsions radiométriques n’impliquent pas nécessairement de distorsions spectrales.

On prendra ici le maximum, avec

| (2.24) |

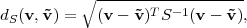

2.1.6.3 Distance de Mahalanobis

Cette distance est une distance statistique entre deux vecteurs v et ṽ

| (2.25) |

S étant la matrice de covariance. Cette distance est couramment utilisée en classification de manière générale. Toutefois, dans le domaine particulier de la classification en hyperspectral, le Spectral Angle (SA) est aussi beaucoup employé.

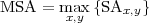

2.1.6.4 Similarité spectrale (SS)

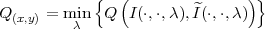

Ce critère apparaît dans [Rup01,Swe01]. Il cherche à mesurer la ressemblance entre deux spectres vus comme des vecteurs à nλ dimensions, v et ṽ.

| (2.26) |

avec

| (2.27) |

et

| (2.28) |

Une valeur de SS faible indique une erreur faible.

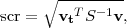

2.1.6.5 RMSCCE (Root Mean Squared Correlation Coefficient Error)

Ce critère est utilisé par Briles dans [Bri96]. C’est une mesure de RMSE sur la matrice de corrélation spectrale (Fig. 1.9) entre la matrice avant compression et la matrice après compression.

Il n’est pas évident de voir le lien entre ce critère et la nature des distorsions détectées.

2.1.6.6 Valeurs propres

La plupart des applications de détection, reconnaissance, identification fonctionnant après une réduction de dimensions par analyse en composantes principales (PCA), il est logique de vérifier l’influence du bruit introduit par la compression sur ces valeurs propres. Dans [Hal99], il est montré que l’introduction d’un bruit de type bruit blanc a tendance à aplatir la courbe des valeurs propres, et donc augmente le nombre de valeurs propres significatives, diminuant le pouvoir de discrimination de la décomposition en composantes principales. Ce critère est à la limite entre application et critère, mais vu sa complexité (temps de calcul) et sa sensibilité à la nature de l’image, il sera plutôt considéré dans les applications.

2.1.6.7 Mesures de détectabilité

Cette mesure est mentionnée dans [Sub00], elle est définie selon l’équation

| (2.29) |

vt étant la cible recherchée dans l’image et v le spectre d’un pixel de la scène, S est la matrice de covariance de l’image. Le critère de qualité qui est alors utilisé est le rapport entre la détectabilité dans l’image originale et la détectabilité dans l’image dégradée :

| (2.30) |

Cette mesure est trop proche d’une application spécifique pour l’utilisation souhaitée. Elle ne sera donc pas utilisée dans la suite.

2.1.7 Critères statistiques évolués

Dans ce paragraphe, nous proposons l’extension de critères particuliers aux images hyperspectrales.

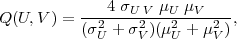

2.1.7.1 Critère Q

Un critère tel que le MSE, bien que largement utilisé ne fournit pas une mesure représentative de la réalité. Un critère évolué statistique est développé par Wang [Wan02a,Wan02b] pour le domaine de l’imagerie classique. Les résultats sont mieux corrélés à la perception visuelle que le MSE bien que ne faisant intervenir que des variables statistiques. Ce critère repose sur l’utilisation de la distorsion structurelle plutôt que sur la sensibilité à l’erreur. Une adaptation de ce critère au domaine vidéo a également été développée [Wan04b]. Une comparaison de cette métrique dans le cadre du VQEG (Video Quality Expert Group) semble donner de bons résultats [VQE03].

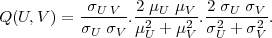

Soit U et V deux ensembles de valeurs (initialement les pixels de deux images) dont on veut évaluer la différence. On verra par la suite comment prendre U et V dans le cas d’une image hyperspectrale.

| (2.31) |

σU V notant l’intercorrélation (𝔼[(U -μU)(V -μV )]), tandis que μ et σ2 sont les notations de la moyenne et de la variance respectivement.

Le facteur Q est alors un nombre dans l’intervalle [-1,1].

On peut décomposer Q de la manière suivante :

| (2.32) |

Il est possible d’interpréter ces différents termes en utilisant des notions propres au traitement d’image : le premier terme est le coefficient de corrélation entre U et V , le second terme mesure l’écart de luminance moyenne et le troisième terme mesure la différence de contraste entre les deux images (en considérant que la variance σ2 donne une estimation du contraste).

Il est possible d’appliquer ce critère à des sous-parties de l’image dans le cas de dégradations locales. Dans [Wan02a], Q est calculé pour des parties d’images par fenêtre glissante. Ensuite, le coefficient final est obtenu en moyennant les valeurs obtenues pour chaque fenêtre.

Les résultats ont été obtenus pour différents types de bruit : bruit gaussien additif, bruit impulsionnel, bruit multiplicatif (speckle), décalage de moyenne (mean shift), rehaussement de contraste, flou et compression JPEG (dégradations structurées). Ces résultats montrent dans tous les cas une meilleure correspondance avec les applications que le MSE.

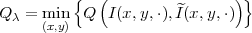

Le critère Q peut être adapté de plusieurs manières aux images hyperspectrales. Nous proposons ici trois adaptations différentes.

∙ Application du critère à chaque pixel (spectre 1D) :

| (2.33) |

où I(x,y,⋅) =  .

.

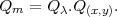

∙ Application du critère à chaque bande (image 2D) :

| (2.34) |

où I(⋅,⋅,λ) =  .

.

∙ Une combinaison de ces deux critères peut être également envisagée avec :

| (2.35) |

Une adaptation du critère Q est réalisée par Alparone [Alp03] pour une image multispectrale de 4 bandes avec utilisation des quaternions. Néanmoins, cette adaptation n’est valable que pour les images de 4 bandes, les quaternions étant à 4 composantes.

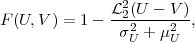

2.1.7.2 Fidélité (F)

Ce critère a été développé par Eskicioglu [Esk93] et utilisé dans [Lam95,Oli98]. On définit la fidélité par :

| (2.36) |

soit pour les images hyperspectrales, une fidélité spatiale définie par :

![∑ [ ^ ]2

x,y,λ I(x,y,λ )- I(x,y,λ)

F(I, ^I) = 1- ------∑-----------2------.

[I(x,y,λ)]

x,y,λ](these65x.png) | (2.37) |

Le terme spatial est ici à comprendre par opposition au domaine de Fourier, le critère F mesure une fidélité de l’image dans son domaine d’origine.

L’adaptation aux images hyperspectrales est réalisée de trois manières différentes. En plus de la formulation ci-dessus considérant les trois dimensions de manière isotrope, on propose les adaptations Fλ et F(x,y) privilégiant respectivement les directions spectrale et spatiales,

| (2.38) |

et

| (2.39) |

2.1.7.3 Structural Content (SC)

Le contenu structurel ou Structural Content (SC) est mentionné dans les mêmes articles que ceux évoquant la fidélité et est défini comme

| (2.40) |

soit

![∑ [ ]2

^I(x,y,λ)

SC = x,∑y,λ-----------.

[I(x,y,λ)]2

x,y,λ](these69x.png) | (2.41) |

2.1.7.4 Normalized Cross-Correlation (NCC)

L’intercorrélation normalisée ou Normalized Cross-Correlation (NCC) est mentionnée dans les mêmes articles que ceux proposant d’utiliser la fidélité

![∑ ^

x,y,λI(x,y,λ )I (x,y, λ)

NCC = ----∑------------2---.

x,y,λ[I(x,y,λ)]](these70x.png) | (2.42) |

L’interprétation physique de ces trois derniers critères (fidélité, SC, NCC) reste plus difficile. Dans [Esk93], Eskicioglu mesure les performances de ces trois critères. L’intercorrélation normalisée, ainsi que le contenu structurel ne donnent pas de très bons résultats. La fidélité semble plus performante.

2.1.8 Critères issus de la théorie de l’information

La théorie de l’information permet de mesurer l’information contenue dans des données. Des critères basés sur cette théorie pourraient être intéressants pour mesurer la perte d’information entre une image originale et une image dégradée.

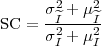

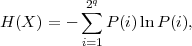

2.1.8.1 Spectral Information Divergence (SID)

Ce critère est dérivé de la distance de Kullback-Leibler [Aia03a]. En notant v = (v0,v1,…,vi,…) on a

| (2.43) |

avec D(v∥ṽ) la distance de Kullback-Leibler, ou divergence entropique, ou discrimination définie entre deux vecteurs par

| (2.44) |

où pi =  et

et  i =

i =  ,

,

d’où

| (2.45) |

Les mêmes remarques peuvent s’appliquer pour le SID et pour le SAM : ce critère peut être considéré en moyenne, ou bien en prenant le maximum de manière à borner l’erreur. De même, ce critère mesure les distorsions spectrales tandis que les distorsions radiométriques n’impliquent pas nécessairement de distorsions spectrales.

On prendra ici le maximum, avec

| (2.46) |

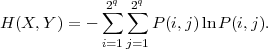

2.1.8.2 Information mutuelle

L’entropie d’un ensemble de valeurs discrètes X à valeurs dans [1,2q] est définie par Shannon [Sha49] comme

| (2.47) |

où P(i) désigne la proportion de X prenant la valeur i.

L’entropie conjointe entre X et Y , qui représente l’information apportée par X et par Y , est alors définie par :

| (2.48) |

L’information mutuelle entre X et Y correspond à la quantité d’information commune à X et à Y

| (2.49) |

et l’entropie conditionnelle s’écrit :

| (2.50) |

Le critère considéré est alors le rapport

| (2.51) |

Ce critère n’est pas largement employé et n’est utilisé que dans peu d’articles [Ma01]. Une étude plus approfondie serait nécessaire pour mesurer son apport sur les images hyperspectrales.

Ces critères s’appliquent bien aux images classiques, car le nombre de pixels est généralement grand devant les valeurs possibles de ces pixels. Par exemple, les images SPOT5 (pour le mode HM) font 12000 × 12000 pixels sur 8 bits, donc environ 144.106 pixels pour 256 valeurs possibles. Vu le large nombre d’échantillons devant le nombre de valeurs prises, il est possible d’effectuer des statistiques. En revanche, comme expliqué dans le chapitre précédent (paragraphe 1.2.4), une image hyperspectrale sur 210 bandes échantillonnées à 12 bits a 4096210 ≈ 10720 valeurs de vecteurs possibles. Les méthodes statistiques ne sont donc plus fiables en considérant les pixels comme vecteurs. Si on veut utiliser ces méthodes, il est indispensable de travailler sur des sous-ensembles de bandes spectrales. Comme la corrélation spectrale est importante également pour des bandes éloignées, il peut être délicat de déterminer ces sous-ensembles.

2.2 Démarche proposée pour l’évaluation des critères

L’objectif consiste à valider les critères qualité retenus par rapport à un panel d’applications courantes en hyperspectral. On peut comparer ce problème à la validation de critères qualité pour les images classiques ou pour les séquences vidéo, l’objectif étant dans ce cas d’avoir des résultats significatifs par rapport à l’œil humain. Ce problème n’est pas simple et a fait l’objet de nombreuses publications au cours des 20 dernières années. La démarche utilisée ici est principalement adaptée des travaux du Video Quality Expert Group [VQE03] dont le but est de déterminer un critère objectif de mesure de la qualité des séquences vidéo.

La démarche du VQEG va être précisée pour mieux comprendre l’adaptation qui en est faite. Un panel de critères qualité mathématiques est d’abord sélectionné, ces critères servent à évaluer diverses dégradations produites sur les séquences vidéo. Tous ces critères sont de type bivariant (full-reference), c’est-à-dire que l’on dispose de la séquence originale pour effectuer le calcul des critères. D’un autre côté, un panel d’observateurs évalue les séquences dégradées en leur donnant une note (Mean Opinion Score ou MOS). Cette évaluation se déroule également par rapport à la séquence vidéo de référence visualisée avant ou après la séquence dégradée. Le but est alors de trouver le critère de qualité qui se rapproche le plus possible de la perception humaine, l’important étant surtout d’avoir une relation stable entre le critère et la notation humaine.

Dans le cas des images hyperspectrales, ce sont rarement des observateurs humains qui vont directement utiliser les images. La quantité d’information est trop importante pour être directement exploitée, on utilise donc des traitements automatisés. Ce sont les traitements automatisés qui vont jouer le rôle des observateurs humains dans l’évaluation des critères.

Des applications de référence sont choisies pour comparer les résultats obtenus par les critères qualité. Ces applications sont détaillées dans la partie 2.2.1. Les tests seront effectués sur plusieurs images dont les particularités sont précisées dans 2.2.2. Dans 2.2.3, les types de dégradations appliquées ainsi que les phénomènes qu’elles modélisent sont expliqués. Le panel d’images de départ présentant des situations variées rencontrées en hyperspectral sera dégradé de différentes manières et à différents niveaux. La qualité de ces images dégradées sera ensuite évaluée par les différents critères qualité et comparée aux résultats obtenus par les applications de référence dans 2.2.4.

Certains articles utilisent directement une application pour qualifier les dégradations des images hyperspectrales : nombre de pixels mal classifiés après application d’un classificateur bayésien K-moyennes [Lur94], détection d’anomalies et identification [She98] mais ceci induit un coût calculatoire important, une difficulté de mise en place et un manque de généralité des résultats. Si on peut proposer un ou plusieurs critères mathématiques de coût calculatoire plus faible mais qui nous permettent d’avoir une idée de l’impact des dégradations sur les applications, cela serait plus intéressant.

2.2.1 Applications de référence

Les applications pour le domaine de l’hyperspectral sont encore au stade du développement. La plupart sont du type DRI (cf. 1.3.3) et procèdent par identification entre les spectres des pixels.

2.2.1.1 Détection d’anomalies

Cette application détecte les anomalies présentes dans une image. Elle fonctionne par poursuite de projection. Une analyse en composantes principales permet de ne conserver que les 12 meilleures composantes. La composante qui maximise le kurtosis 1 des valeurs de l’image est sélectionnée. Les points en queue de distribution sont alors considérés comme étant les anomalies. Un programme a été développé à l’ONERA à partir de l’article de Chiang [Chi01].

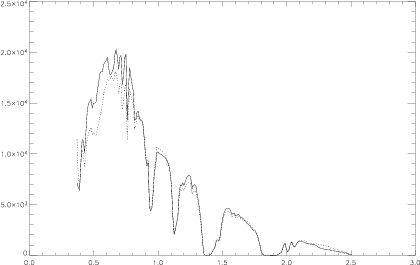

Pour vérifier la bonne détection ou non des cibles recherchées, on introduit artificiellement des cibles subpixels en différentes proportions. On réalise une combinaison entre le spectre présent sur l’image et un spectre d’anomalie. Ce spectre d’anomalie est généré à partir d’un spectre présent dans une librairie spectrale. Les effets atmosphériques sont simulés sur ce spectre pour calculer la luminance qui serait vue à l’altitude du capteur. L’image testée pour ce cas étant principalement constituée de zones sableuses et rocheuses (site Railroad Valley, voir D), le spectre d’une peinture couleur sable a été utilisé pour réaliser les mélanges. La figure 2.1 illustre la similitude entre les deux spectres. 100 cibles sont insérées dans des proportions variant entre 10% et 90% de la surface du pixel. Les bandes de valeurs très faibles (absorption par la vapeur d’eau) sont retirées pour ne pas perturber la détection.

|

|

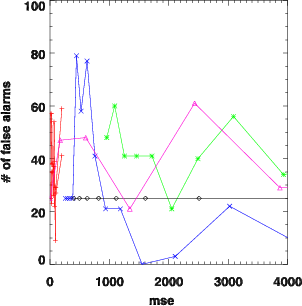

Deux critères classiques pour évaluer les performances de la détection sont la proportion de cibles correctement détectées ainsi que le nombre de fausses alarmes. Les fausses alarmes sont les pixels signalés comme étant des cibles alors qu’ils n’en sont pas. Tout système de détection est réglé en fonction d’un compromis entre la quantité de fausses alarmes par rapport au nombre de pixels correctement détectés. Ce compromis donne lieu au tracé d’une courbe appelée COR (Caractéristiques Opérationnelles du Récepteur ou ROC curve) servant à évaluer les performances du système de détection en traçant la probabilité de détection en fonction de la probabilité de fausse alarme.

La proportion de cibles insérées est faible par rapport au nombre de pixels dans l’image (100 cibles pour 65 536 pixels) puisqu’il s’agit d’une détection d’anomalies. De plus, l’algorithme de détection est très sensible aux réglages des paramètres (nombre de boucles, seuil …) et aux données de l’image. Des perturbations de même nature, mais dont la réalisation est aléatoire (bruit blanc ou déregistration par exemple) donneront des résultats complètement différents pour deux réalisations successives d’amplitude égale. La dispersion des résultats est donc assez importante et l’extrapolation des conclusions est délicate.

2.2.1.2 Classification

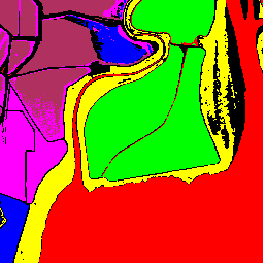

Les simulations pour la classification sont réalisées sur l’image Moffett du capteur AVIRIS (voir annexe D) qui présente des zones homogènes contrastant fortement entre elles (marais salants) dans une partie de l’image et une zone plutôt urbaine dans l’autre partie.

La classification réalisée est une classification supervisée. Des régions d’intérêt sont définies pour servir de base à la classification. Six régions sont finalement gardées. Les pixels sont classifiés par rapport à leur distance au sens du Spectral Angle (Eq. 2.22) ou de Mahalanobis (Eq. 2.25) aux pixels moyens des régions d’intérêt, une classification par Maximum de Vraisemblance est également effectuée. Pour la classification par Spectral Angle un seuil est fixé à un SAM de 0.15rad. Certains pixels se trouveront à des distances supérieures, et ne seront donc pas classifiés. L’importance de cette classe de rejet sera précisée par la suite.

En l’absence de réalité terrain pour qualifier les résultats de la classification en absolu, on compare les variations de classification causées par les dégradations par rapport à l’image non dégradée. Pour chaque dégradation appliquée, deux valeurs sont utilisées : le nombre de pixels qui ne sont pas classifiés (dans le cas où on a une classe de rejet) et le nombre de pixels qui ont changé de classe.

La quantité de données étant assez importante (315 000 pixels sur 224 bandes) par rapport au nombre de classes, les résultats sont peu sensibles aux différentes réalisations des dégradations aléatoires dans le cas du bruit blanc.

2.2.1.3 Valeurs propres

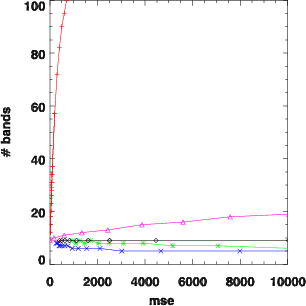

Pour beaucoup d’applications, un prétraitement est d’abord effectué pour réduire le nombre de dimensions. Dans la plupart des cas, une projection sur les composantes principales (ACP ou PCA) est effectuée. Seules les composantes dont la valeur propre est supérieure à un seuil arbitraire sont conservées.

Hallidy [Hal99] a montré que la présence de bruit dans l’image provoque un aplatissement de la répartition des valeurs propres : la décroissance est moins rapide, il faudra donc garder plus de bandes.

On va donc également considérer ces valeurs propres comme une application sur laquelle les effets des distorsions devront être mesurés. Le critère finalement retenu est le nombre de valeurs propres que l’on doit conserver pour garder 99.9% de la somme des valeurs propres, ce qui correspond à 99.9% de l’énergie de l’image.

Cette application est assez stable, mais il est difficile d’évaluer la qualité de l’image directement à partir de ce critère. Selon les applications qui se trouvent après, une diminution du nombre des valeurs peut être considérée comme une variation positive ou négative.

2.2.2 Images hyperspectrales testées

Toutes les images testées dans cette partie sont des images AVIRIS. Les caractéristiques de ce capteur sont rappelées dans l’annexe E.2.1. Le choix s’est porté sur ce capteur pour son rapport signal sur bruit important sur les images fournies. En effet, un faible bruit sur les images originales est indispensable pour mesurer l’influence du bruit ajouté lors des simulations. Plusieurs images hyperspectrales sont sélectionnées, ces images représentent des zones variées, qui peuvent être uniformes ou hétérogènes (désert, ville, plans d’eau …). Les images utilisées sont présentées dans l’annexe D.

Dans le cas de la détection, les simulations s’effectuent sur des échantillons de 256 × 256 pixels du site de Railroad Valley. Pour la classification, les simulations se font directement sur des vignettes d’images AVIRIS 256 × 256 (site Moffett) en conservant toutes les bandes. Ces simulations ont lieu sur des parties homogènes de l’image (zones de marais salant, uniformes) et sur des zones plus hétérogènes (zones de ville). Les résultats de référence pour les classifications par SAM sont présentés sur les figures 2.3 à 2.6.

|

2.2.3 Dégradations appliquées

Différentes dégradations sont appliquées aux images afin de simuler au mieux les pertes dues à la compression ou à des défauts instrumentaux.

2.2.3.1 Bruit blanc gaussien additif

Le premier type de dégradation appliqué est un bruit blanc gaussien additif dont on modifie la variance. Ce bruit modélise les défauts d’acquisition de l’appareil au niveau électronique, ainsi que le bruit de quantification. On ajoute à l’image un tirage aléatoire de ce bruit blanc. Certains critères ou certaines applications posséderont une sensibilité différente à la réalisation du bruit.

2.2.3.2 Flou

La deuxième modification est un flou appliqué à l’image, selon la dimension spectrale, les dimensions spatiales ou selon les trois dimensions. Ce flou représente les défauts provoqués sur l’image par un défaut de FTM (taille de la tache image), par une compression par ondelettes (qui a tendance à rendre l’image floue) ou par une réduction du pas d’échantillonnage. Le flou est appliqué par un filtre moyenneur sur une fenêtre de taille variable (1 à 7 pixels de large selon les dimensions spatiales ou spectrale), la contribution des pixels voisins peut également être réduite (présence d’un coefficient d’atténuation sur le filtre).

2.2.3.3 Phénomène de Gibbs

Le troisième type de bruit ajouté à l’image est un phénomène de Gibbs qui provoque un rebond après les fortes transitions. Cet effet apparaît lorsqu’on applique un filtre passe-bas à un signal [Mal97]. Il est modélisé en appliquant un filtre de Wiener modifié [Oli98]. Le filtrage n’est réalisé que pour les images spatiales (longueur d’onde par longueur d’onde).

2.2.3.4 Compression

La quatrième dégradation utilisée est la compression par JPEG 2000. La norme est utilisée avec transformée en ondelettes pour décorréler les bandes spectrales entre elles. Différents débits sont utilisés pour produire des dégradations de forte ou faible amplitude.

2.2.4 Démarche

Un grand nombre de critères qualité ont été programmés. Les différentes images pour les différentes dégradations sont successivement évaluées par rapport aux images originales. Une évaluation est également réalisée par rapport aux applications de référence.

La comparaison entre les résultats de l’évaluation par les applications ou par les critères de qualité est souvent mise en relation par un facteur de corrélation. Des résultats fortement corrélés indiquent que le critère de qualité identifie l’impact des dégradations sur l’application. C’est la démarche la plus simple et la plus rapide à effectuer.

Dans [Bri04], Brill présente une méthode permettant de comparer des critères de qualité objectifs pour les séquences vidéos par rapport aux évaluations obtenues par un panel d’observateurs. Cette méthode est plus complète qu’une simple mesure de corrélation. Il est possible d’effectuer un parallèle entre les mesures subjectives des observateurs dans le cas de séquences vidéo et les résultats objectifs des applications dans le cas de l’hyperspectral.

|

Néanmoins, la méthode n’est pas directement utilisable, principalement parce que dans le cas des séquences vidéo, il y a une seule application, l’observateur humain, qui possède une variabilité statistique. Dans le cas des images hyperspectrales, il y a diverses applications qui requièrent des propriétés différentes. Il faut donc pouvoir qualifier plus précisément la nature des dégradations. Les nuages de points obtenus par la méthode complète de Brill (Fig. 2.6) sont assez délicats à interpréter et ne permettent pas de séparer les différents cas pour lesquels certains critères sont plus efficaces.

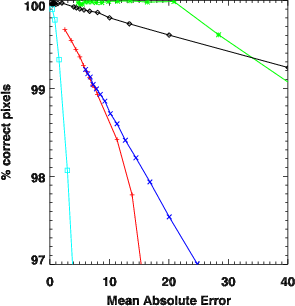

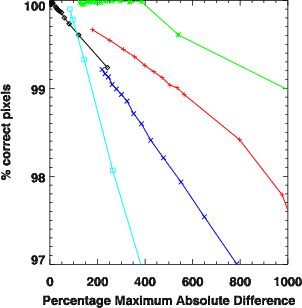

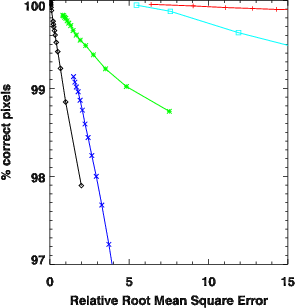

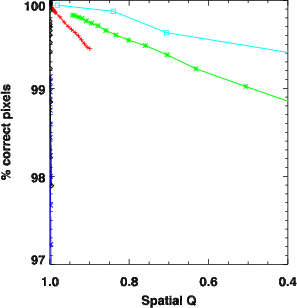

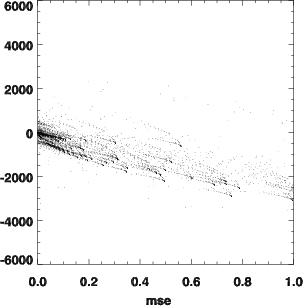

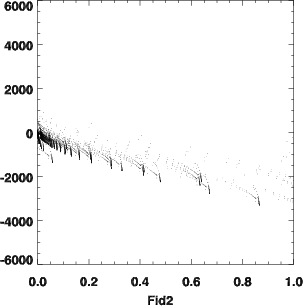

La méthode est donc modifiée pour donner des résultats interprétables dans le cas des images hyperspectrales. On appelle situation, une certaine dégradation avec un certain niveau sur une image donnée. Pour chaque situation i, un score est calculé pour un critère qualité (noté Oi, score objectif) et pour une application (noté Si score subjectif). Environ 10 000 situations ont été testées et pour chaque cas, le score a été calculé pour diverses applications (temps de calcul de l’ordre de la minute ou de l’heure) et pour les 15 critères testés (temps de calcul de l’ordre de la seconde). Les courbes représentant directement les performances de l’application par rapport au critère qualité observé (points (Oi,Si)) sont plus explicites et permettent de repérer facilement les dégradations faisant plus réagir certains critères (figures 2.8 à 2.15).

2.3 Résultats de l’étude

Une sélection des courbes obtenues pour tous les critères de qualité testés est présentée ci-dessous. Dans ce qui suit, sont expliqués la manière de lire ces courbes, ainsi que le type d’interprétation que l’on peut en tirer. La fin de ce chapitre détaillera les conclusions obtenues à partir des simulations effectuées.

2.3.1 Présentation des résultats

Les courbes sont tracées pour 15 critères de qualité, pour différents niveaux et types de dégradation. Ces résultats sont comparés aux performances des applications sélectionnées.

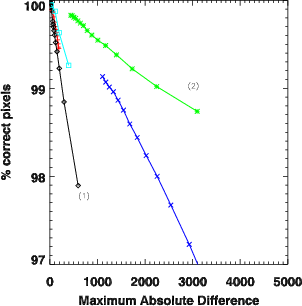

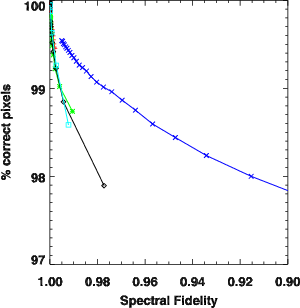

Chaque courbe est tracée en représentant la valeur du critère qualité en abscisse et la performance de l’application en ordonnée. Chaque point correspond à une situation donnée, i.e. un type et un niveau de dégradation appliqué à une image. Pour faciliter la lecture, la valeur du critère qualité représentant une qualité maximum est représentée à gauche. L’image d’origine se trouve donc ainsi positionnée dans le coin supérieur gauche. Différents symboles sont utilisés pour les différents types de dégradation, permettant ainsi de distinguer les points forts des applications :

|

Un critère qualité répond correctement s’il donne une faible dispersion des points, si possible selon une direction oblique (Fig. 2.9). Si on obtient ce cas de figure, cela signifie que lorsque les performances de l’application baissent (i.e. l’ordonnée diminue), le critère qualité en rend bien compte et dans une bonne proportion. Au contraire, si les points sont dispersés, cela montre que le critère étudié va réagir plus fortement à certaines dégradations par rapport à d’autres (Fig. 2.8). Dans le cas où la réponse est concentrée le long d’un axe vertical (Fig. 2.8 courbe 1), c’est que le critère ne réagit pas à des dégradations qui sont pénalisantes pour l’application étudiée, il sous-estime l’importance de cette dégradation. À l’inverse, lorsque la réponse est concentrée le long d’un axe horizontal (Fig. 2.8 courbe 2), le critère surestime l’impact de la dégradation sur l’application.

|

2.3.2 Interprétation graphique et sensibilité des applications

Parmi les applications envisagées initialement (détection d’anomalies, classifications et calcul des valeurs propres), certaines s’avèrent ne pas avoir les propriétés nécessaires (stabilité, monotonie) pour conclure.

En effet, les performances de la détection sont très instables et dépendent fortement et irrégulièrement de la dégradation appliquée. Par exemple, dans le cas du bruit blanc (+), les performances sont très sensibles à la réalisation du bruit (Fig. 2.9). Cela peut s’expliquer par le fait qu’il n’y a qu’un nombre faible de cibles insérées dans l’image (environ 100 pour 10 000 pixels), des résultats statistiques sont difficilement fiables avec un nombre aussi faible d’échantillons. D’un autre côté, comme l’application est une application de détection d’anomalies, il n’est pas possible d’insérer un plus grand nombre de cibles. Les conclusions vont donc s’appuyer principalement sur les performances de l’application de classification qui sont beaucoup plus fiables et qui dépendent peu des différentes réalisations des dégradations aléatoires.

Pour l’analyse des résultats concernant l’ACP, on ne peut pas tirer de conclusion directe sur la performance des applications qui viendront après, mais juste avoir une idée de l’impact de la dégradation. On remarque principalement que l’ACP est très sensible à la présence de bruit blanc, moins sensible à la présence de flou, et complètement insensible à un phénomène de Gibbs (Fig. 2.10).

|

Ainsi, nos conclusions quant au choix de critères qualité vont s’appuyer essentiellement sur les résultats des méthodes de classification.

Les résultats pour la classification sont étudiés pour une même méthode de classification (SAM) sur deux images différentes pour s’assurer que les résultats seront applicables à d’autres images. Les deux images choisies sont deux parties de l’image Moffett acquise par AVIRIS. La première est une zone plutôt uniforme, tandis que la deuxième est une zone de ville très découpée.

D’autre part, pour vérifier que les résultats sont généralisables à d’autres méthodes de classification, les mesures sont effectuées pour la même image avec trois méthodes de classification différentes : SAM, Mahalanobis et Maximum de vraisemblance. Les résultats pour les classifications de Mahalanobis et Maximum de vraisemblance sont très similaires : très grande sensibilité à la présence de bruit blanc, peu de sensibilité au flou spectral, mais présence d’un effet de seuil important. En revanche, la classification par SAM est très peu sensible au bruit blanc et ne présente pas cet effet de seuil sur un flou spectral (Tab. 2.1) .

|

La structure des erreurs de classification est assez caractéristique lorsqu’il n’y a pas de classe de rejet. Même avec l’introduction d’un bruit blanc, les erreurs ne sont pas réparties aléatoirement sur l’image, elles se concentrent aux limites entre les zones. En effet, les pixels se trouvant entre deux zones ont de fortes chances d’être des pixels de mélange et possèdent des spectres moins caractéristiques. Ce sont donc ces pixels qui vont changer de classe en premier. Dans le cas de la classification par SAM, la présence de la classe de rejet permet d’atténuer cet effet.

2.3.3 Interprétation des critères de qualité

Les critères de qualité testés sont :

- MSE (Eq. 2.4), RRMSE (Eq. 2.8), MAD (Eq. 2.13), PMAD (Eq. 2.14), MAE (Eq. 2.3) qui sont calculés de manière globale sur l’image ;

- SAM (Eq. 2.22), SS (Eq. 2.26), SID (Eq. 2.43) et Pearson (Eq. 2.28) qui sont calculés pour chaque pixel (vu comme un vecteur). La valeur retournée pour l’image est la valeur maximum (pour SAM, SS et SID) ou la valeur minimum (pour Pearson) ;

- Les critères Q (Eq. 2.31) et F (Eq. 2.36) sont adaptés de différentes manières : ils sont soit calculés pour chaque pixel (vu comme un vecteur), la valeur finale étant le minimum entre les différents vecteurs (Eq. 2.38 et Eq. 2.33), soit calculés pour chaque bande spectrale, la valeur finale étant le minimum entre les différentes bandes (Eq. 2.39 et Eq. 2.34).

Les résultats obtenus sont très hétérogènes, certains critères surestimant ou sous-estimant beaucoup l’impact de certaines dégradations. L’impact du flou spectral (*) par exemple est largement surestimé par la plupart des critères : tous les critères (Fig. 2.12 par exemple) sauf Fλ surestiment cet impact. Dans le cas de la classification par Mahalanobis, le flou spectral (*) provoque un effet de seuil (Fig. 2.13). Certains critères sont très sensibles à la présence de bruit blanc (+) (RRMSE, PMAD, MAE et SID), alors que la classification par SAM n’y réagit quasiment pas (Fig. 2.14). Q(x,y) est complètement insensible aux dégradations touchant les plans spatiaux : aucune sensibilité à un phénomène de Gibbs (♢) ou à un flou spatial (×), bien que ces dégradations déforment également le spectre (Fig. 2.15).

Deux types de critères peuvent être intéressants. Un critère réagissant uniformément à toutes les dégradations de la même manière que les applications serait idéal, mais comme on l’a vu dans la partie précédente, toutes les applications ne réagissent pas de la même manière. D’un autre côté, les critères réagissant fortement ou pas du tout à une dégradation sont intéressants pour permettre de qualifier la nature de la dégradation.

|

|

2.3.4 Évaluation quantitative

La représentation graphique des résultats permet de découvrir les tendances dominantes parmi les critères considérés. Ce n’est cependant pas suffisant, des comparaisons quantitatives sont nécessaires. Deux problèmes se posent pour cela. Les différents critères n’ont pas d’échelle commune entre eux et donc ne sont pas directement comparables. Appliquer une normalisation parait difficile à cause du choix arbitraire du niveau de référence qui serait nécessaire. Ensuite, la sensibilité des différents critères à une dégradation n’est définie que par rapport aux autres dégradations. Par exemple, dire que le RRMSE est très sensible au flou spectral n’a de sens que parce qu’il est moins sensible relativement aux autres dégradations (Fig. 2.14). Pour surmonter ces difficultés, c’est la contribution relative de chaque dégradation qui est calculée.

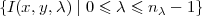

Pour chaque critère de qualité C, une valeur moyenne du critère est calculée

pour chaque dégradation. Chaque critère est donc caractérisé par CBB,

CFlouSpect., CFlouSpat., CGibbs et CJPEG2000 où la notation  correspond à la

valeur moyenne et l’indice indique le type de dégradation. Pour trouver le critère

le plus sensible à chaque dégradation, les valeurs moyennes précédentes sont

remplacées par leurs contributions relatives, i.e. CBB∕C, CFlouSpect.∕C,

…où

correspond à la

valeur moyenne et l’indice indique le type de dégradation. Pour trouver le critère

le plus sensible à chaque dégradation, les valeurs moyennes précédentes sont

remplacées par leurs contributions relatives, i.e. CBB∕C, CFlouSpect.∕C,

…où

| (2.52) |

Ces contributions relatives sont calculées pour chaque critère ainsi que pour diverses méthodes de classification. Les résultats sont donnés dans les tableaux 2.2 et 2.3.

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Les valeurs signifient par exemple que la contribution dans le RRMSE (sur l’image moffett4, dans le tableau 2.3) :

- du bruit blanc est de 51.54%,

- du flou spectral est de 4.39%,

- du flou spatial est de 8.05%,

- de l’effet de Gibbs est de 0.86%,

- de JPEG 2000 est de 35.16%.

Le total est bien sûr de 100%. Ces valeurs dépendent du choix arbitraire des amplitudes des distorsions et doivent donc être comparées aux autres critères ainsi qu’aux applications. Pour le RRMSE, la comparaison avec la classification par SAM montre que le RRMSE surestime l’impact du bruit blanc (51.54% contre 4.24% d’influence pour la classification par SAM) et sous-estime l’effet de Gibbs (0.86% contre 12.03% pour la classification par SAM), confirmant l’interprétation graphique que l’on pouvait avoir sur la figure 2.14. Les extrema en gras dans le tableau 2.3 sont sélectionnés en fonction des résultats sur les deux images.

2.3.5 Critères de qualité proposés

Certains critères permettent de bien rendre compte de l’importance des dégradations causées quel que soit le type de ces dégradations. C’est le cas notamment du critère Fλ particulièrement bien en phase avec la classification par SAM. Toutefois, le critère reflétant le mieux les résultats de la classification par SAM est logiquement le critère MSA mais par contre, il ne permet pas de retrouver les sensibilités des autres applications.

On voit ainsi que les différentes applications envisagées réagissent différemment aux mêmes dégradations. Il n’est donc pas possible de sélectionner ou de définir un seul critère magique qui refléterait toutes les applications. Une combinaison d’un certain nombre de critères est nécessaire pour rendre compte de manière complète de l’influence des dégradations. Nous proposons de ne garder que 4 critères qui vont permettre de quantifier et de qualifier la dégradation sur l’image. Ces 4 critères sont : Fλ, RRMSE, MAE et Q(x,y) (Tab. 2.4). Ces critères sont sélectionnés comme étant les extrema de sensibilité pour les différentes dégradations. Pour renforcer cet ensemble de critères, le MAD est ajouté pour permettre de donner une borne supérieure à l’erreur sur l’ensemble du cube hyperspectral. Connaître l’erreur maximale est intéressant particulièrement dans le cas de la détection d’anomalies, pour s’assurer de ne pas rajouter ou d’éliminer des cibles.

|

2.4 Conclusion

Parmi les 15 critères de qualité étudiés, 5 ont été sélectionnés pour leurs propriétés. Comme nous l’avons vu, les 5 critères sélectionnés peuvent être utilisés pour caractériser la nature et le niveau de dégradation affectant une image ainsi que pour prédire les performances d’une application donnée. Cependant, seules des applications de classification ont fourni des résultats utilisables ici, la détection d’anomalies donnant des résultats trop aléatoires et l’analyse en composantes principales des résultats difficilement interprétables. Il pourrait être intéressant d’utiliser la même méthode pour d’autres applications : indice de végétation (NDVI), qualité de l’eau...

Le but de cette étude sur les critères qualité était de trouver des critères pertinents pour diverses applications hyperspectrales. Une méthode générale est définie pour pouvoir comparer la sensibilité de divers critères par rapport aux applications.

De plus cette étude démontre la nécessité d’utiliser une combinaison de plusieurs critères plutôt qu’un seul, chacun ayant une sensibilité différente selon les dégradations.

Dans la suite de cette étude, on va s’intéresser à la compression des images hyperspectrales. Afin de pouvoir comparer les résultats des méthodes de compression que nous allons proposer à des méthodes existantes, nous utiliserons des critères communs dans la littérature : PSNR ou SNR essentiellement. Ce n’est qu’en fin d’étude, lorsque nous aurons proposé une méthode de compression intéressante par rapport à celles existantes, que nous illustrerons les résultats en termes des critères sélectionnés dans le présent chapitre.

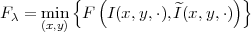

(a)

(a)

(b)

(b)